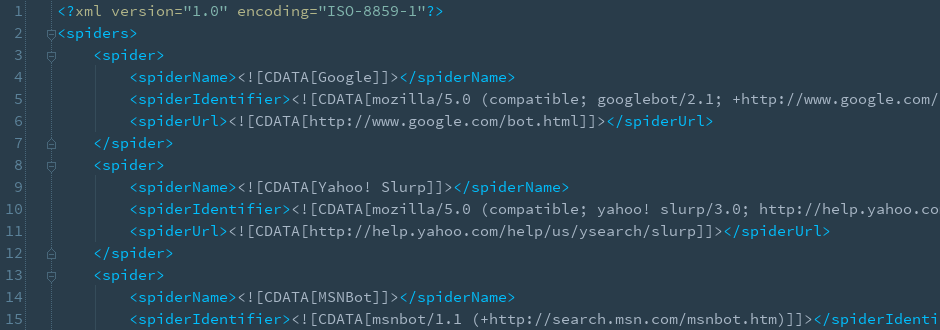

Wenn man sich mal die verschiedenen Useragents von bekannten Suchmaschinenbots anguckt, dann sind diese zwar fast alle gleich aufgebaut, aber man kann sie leider nicht mit einem einzigen regulären Ausdruck matchen. Wenn man zum Beispiel mit einem Skript überprüfen möchte, ob der aktuelle Useragent ein Suchmaschinenbot ist, dann wird es immer nervig, wenn man für jeden Suchmaschinenbot einen eigenen regulären Ausdruck erstellen muss.

Und wenn dann ein neuer Suchmaschinencrawler oder sonstiger Bot auftaucht, dann kann man diesen wieder in die Liste mit den regulären Ausdrücken aufnehmen. Das ist nicht nur zeitraubend, sondern auch verdammt nervig.

Meine Idee wäre jetzt, dass eine einheitliche Kennung geschaffen wird, die die Suchmaschinenbots in ihren Useragent-Strings implementieren, so dass man diese alle mit einem einzigen regulären Ausdruck matchen kann. Man könnte zum Beispiel am Anfang des Strings die Zeichenkette [bot] oder [crawler] einsetzen.

Wenn das zumindest von allen großen und bekannten Suchmaschinen umgesetzt werden würde, dann könnte man diese alle schon mit einem einzigen, anstatt vielen einzelnen regulären Ausdrücken matchen.