Betriebssystemwechsel: Von Debian 7 wieder zurück zu Windows 7

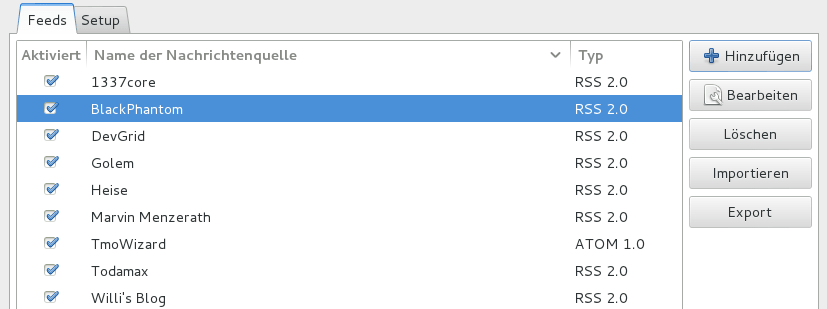

Vor ungefähr zweieinhalb Monaten habe ich einen Betriebssystemwechsel vollzogen und bin von Windows 7 komplett auf Debian-Linux umgestiegen, weil ich Linux mal ausprobieren und es auch tatsächlich produktiv nutzen wollte. Der Hauptgrund, warum ich mich für Debian entschieden habe, war das elegante Design der GNOME-Shell und weil unter Debian standardmäßig keine proprietäre, sondern nur quelloffene Software mit dabei ist.

Außerdem wollte ich nicht mehr von großen […] weiterlesen